Что такое Crawlability: 11 способов исправить ошибки Crawl

Здравствуйте, мои дорогие SEO-друзья и энтузиасты! Сегодня я хотел бы поговорить о crawlability, наиболее распространенных проблемах crawlability и способах их решения. Этот жизненно важный фактор может навредить вашему рейтингу, трафику и видимости сайта в результатах поиска. Прежде чем перейти к рассмотрению ошибок ползания, давайте выясним, что такое ползаемость и как она влияет на SEO.

Что такое crawlability?

Простыми словами, crawlability — это способность ботов поисковых систем обнаруживать и правильно просматривать страницы вашего сайта. Что касается технического SEO, то это важная вещь, которую вы должны проверить, потому что если Googlebot не сможет найти ваши веб-страницы, они никогда не займут верхние строчки в результатах поисковых систем.

Обратите внимание на то, что «ползаемость» и «индексируемость» — это разные вещи. Последняя относится к способности поисковых систем правильно находить контент, который они просматривают, и добавлять его в свой индекс. Google показывает в результатах поисковой выдачи только те веб-страницы, которые можно просмотреть и проиндексировать.

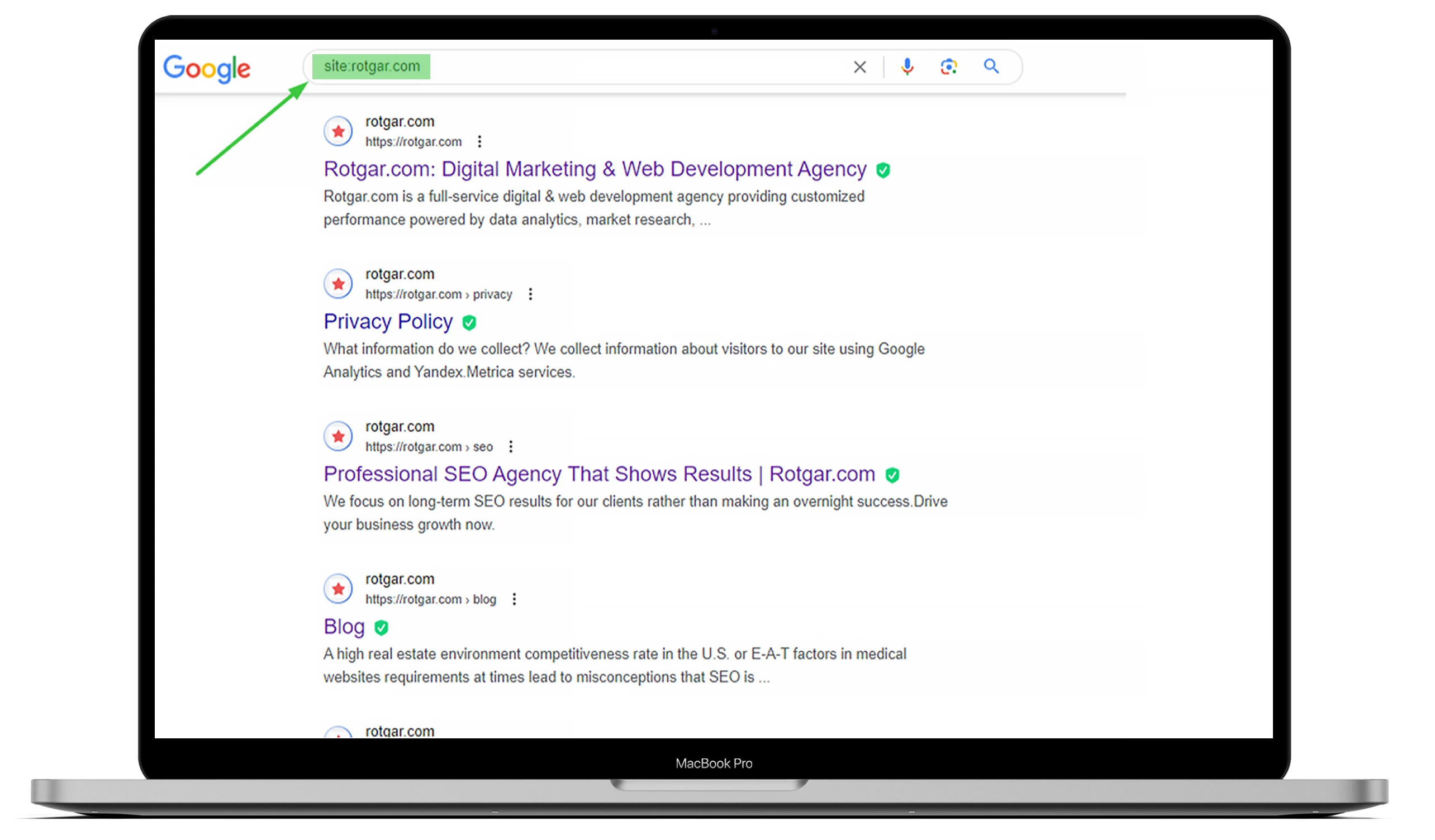

Чтобы узнать, сколько страниц на вашем сайте было проиндексировано, зайдите в Google и введите «site:» с URL-адресом сайта. Вы можете посмотреть пример ниже, но если вы хотите, чтобы все было сделано за вас, добро пожаловать к нам на аутсорсинг!

Вы должны понимать, что боты поисковых систем, также известные как веб-краулеры, всегда работают, сканируют содержимое и индексируют найденные ими веб-страницы. Как только бот Google обнаружит какие-либо изменения, он обновит данные.

Многие вещи могут повлиять на способность вашего сайта к заползанию, но в этой статье мы расскажем о наиболее распространенных проблемах.

Влияние ошибок, допускаемых поисковыми роботами, на SEO

Если боты поисковых систем сталкиваются с проблемами, связанными с проходимостью вашего сайта, это может существенно повлиять на SEO. Ваши веб-страницы не будут отображаться в результатах поиска, если бот Google не знает, релевантен ли контент определенному поисковому запросу.

Это означает, что они не смогут их проиндексировать, а это может привести к потере конверсий и органического трафика. Вот почему для высокого рейтинга в поисковых системах необходимо иметь удобные для просмотра и индексируемые страницы. Другими словами, чем лучше ваш сайт, тем больше вероятность того, что ваши страницы будут индексироваться и лучше ранжироваться в Google.

Как найти ошибки ползания в Google Search Console

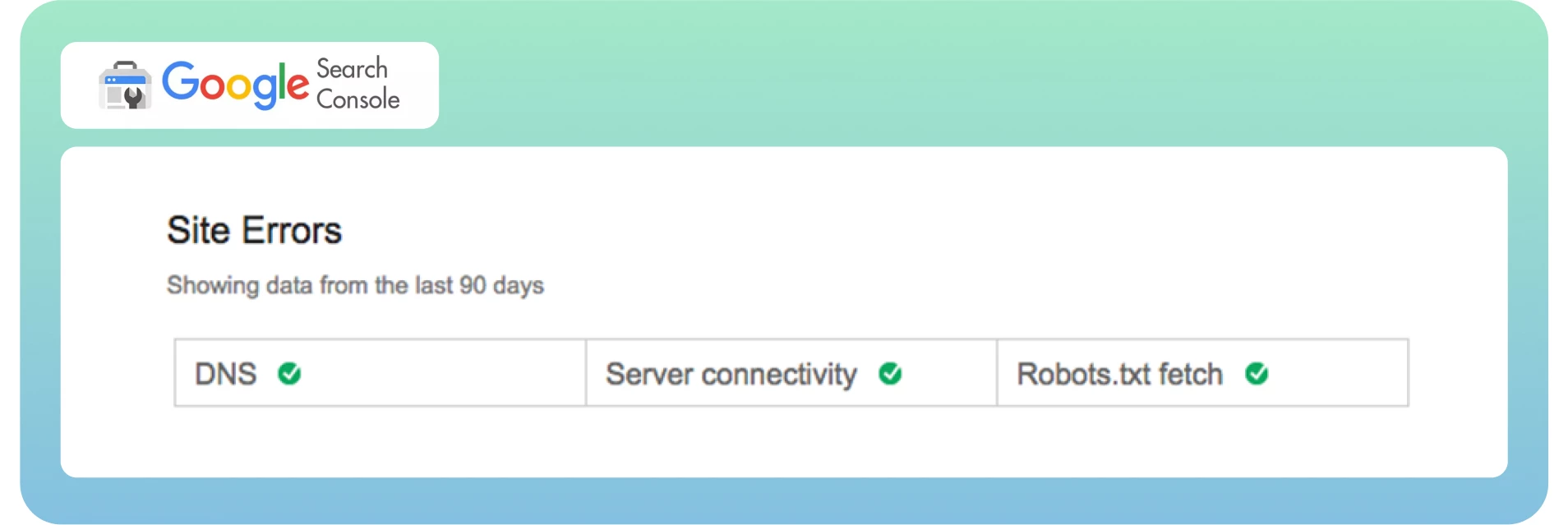

Теперь мы знаем, что такое «ползучесть» и «ошибки ползания» и как они влияют на SEO. Пришло время быстро найти эти ошибки на панели управления. Как вы, возможно, знаете, в Google Search Console ошибки ползания делятся на два раздела: Ошибки сайта и Ошибки URL. Это отличный способ различать ошибки на уровне сайта и страницы.

Обычно ошибки сайта считаются более срочными и требуют немедленного принятия мер, чтобы не повредить юзабилити вашего сайта. Я рекомендую на 100% исключить ошибки в этом разделе.

Ошибки URL звучат менее катастрофично и более специфично для отдельных веб-страниц, поскольку эти ошибки влияют только на определенные страницы, а не на весь сайт в целом.

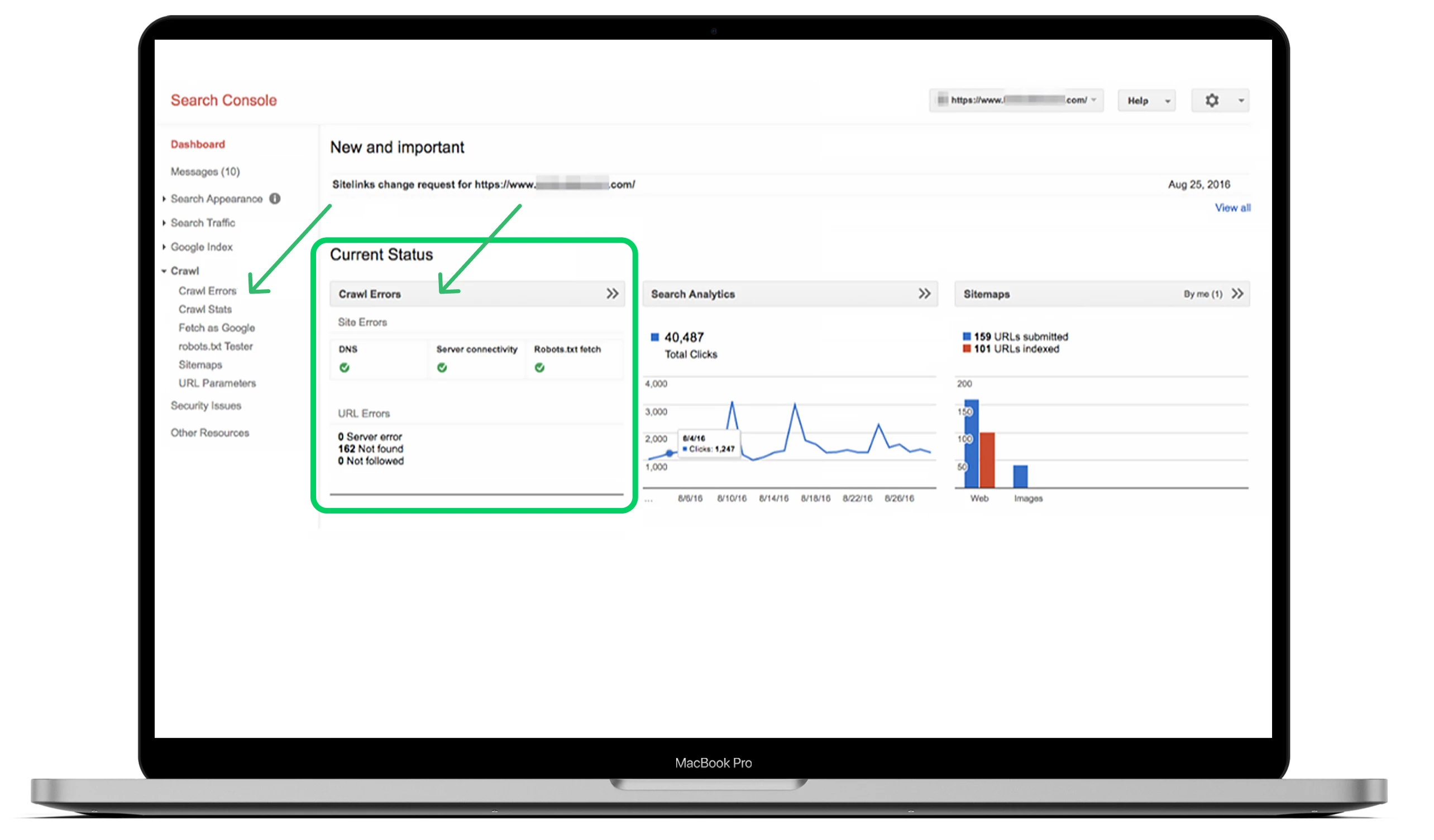

Лучший способ найти ошибки — зайти на главную панель, посмотреть раздел «Crawl» и нажать «Crawl Errors».

В идеале, чтобы избежать серьезных проблем и сохранить здоровье сайта в будущем, необходимо проверять ошибки ползания не реже одного раза в три месяца.

Топ-10 проблем с наползаемостью и способы их устранения

Теперь давайте рассмотрим наиболее распространенные проблемы с проходимостью и их решения, чтобы соответствующим образом оптимизировать ваш сайт.

1. 404 ошибки

-Ошибка 404 — это одна из самых сложных и самых простых проблем среди всех ошибок одновременно.

-Теоретически, ошибка 404 относится к способности Googlebot проползти по определенной странице, которой нет на вашем сайте.

-На практике в Google Search Console вы можете увидеть множество страниц как 404-е.

Вот что утверждает Google:

«404 ошибки не сильно влияют на производительность и рейтинг вашего сайта в Google, поэтому вы можете смело их игнорировать».

Исправление 404 ошибок, когда ваши важные веб-страницы сталкиваются с этими проблемами, имеет большое значение. Убедитесь, что вы различаете страницы, чтобы избежать ошибок и найти корень проблемы. Последнее действительно важно, особенно если страница получает важные ссылки из внешних источников и имеет большой органический трафик на вашем сайте.

Решение

Вот несколько шагов, которые помогут исправить важные страницы с 404 ошибкой:

Дважды проверьте, является ли страница с 404 ошибкой корректной и полученной из вашей CMS, а не в режиме черновика.

Проверьте, на какой версии вашего сайта появляется ошибка: WWW или не WWW и http или https.

Добавьте 301 редирект на наиболее релевантную страницу на вашем сайте, если вы не обновляете страницу.

Если ваша страница больше не живет, обновите ее и сделайте снова живой.

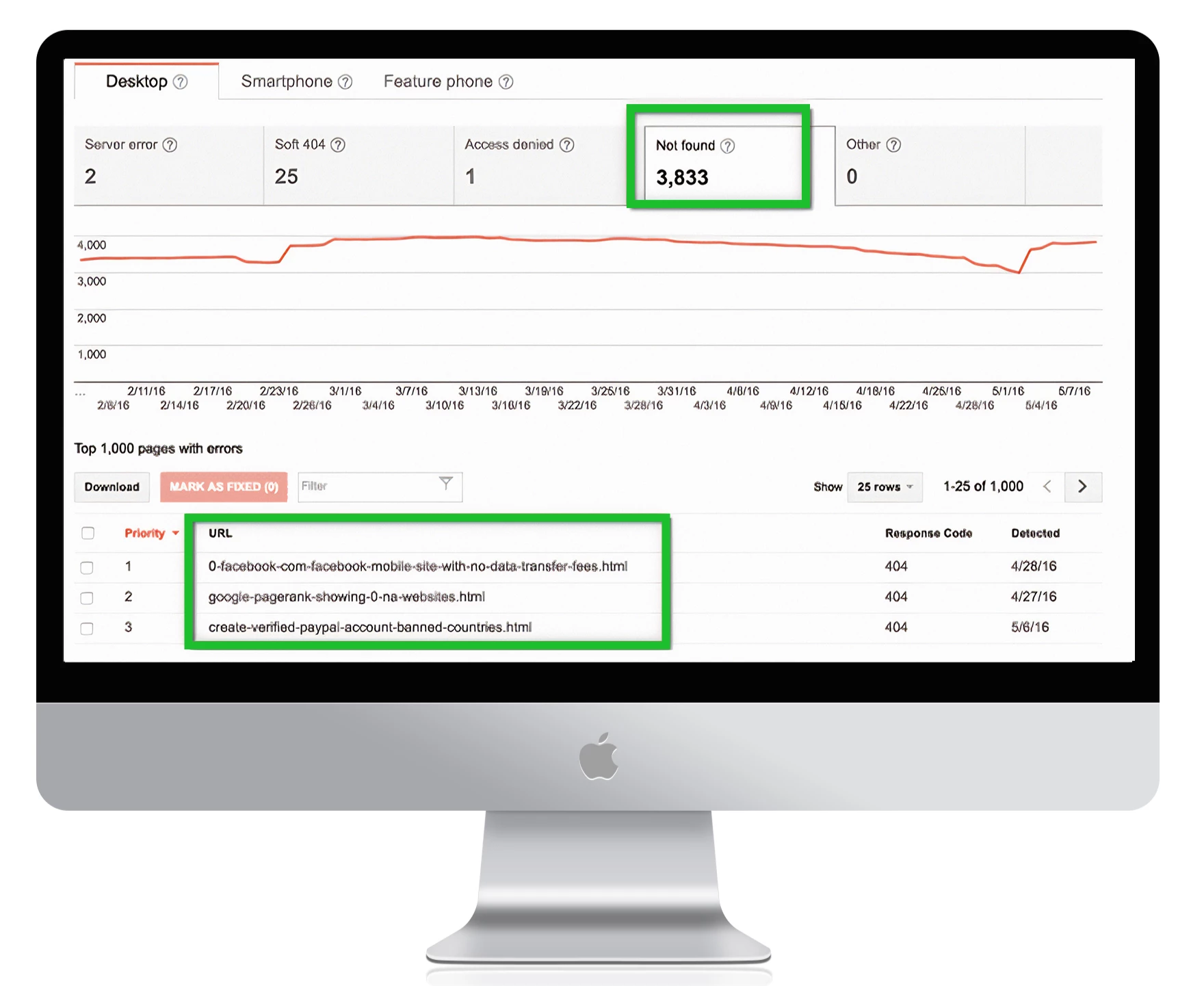

Чтобы найти все страницы с 404 ошибками в Google Search Console, перейдите в раздел Crawl Errors -> URL Errors и нажмите на все ссылки, которые вы хотите исправить:

1. Обратите внимание:

если у вас есть пользовательская страница 404, которая не возвращает статус 404, Google отметит ее как soft 404. Это означает, что страница не содержит достаточно полезного контента для пользователей и возвращает статус 200. Технически она существует, но пуста, что снижает производительность ползания по вашему сайту.

Ошибки Soft 404 могут сбить с толку владельцев сайтов, поскольку они выглядят как странный гибрид 404 и стандартной веб-страницы. Убедитесь, что Googleblog не считает самые важные страницы вашего сайта «мягкими 404″.

2. Неполноценные ссылки

Поисковые системы могут ошибаться, не просматривая ссылки на странице сайта. Тег nofollow указывает Googlebot не переходить по ссылкам, что приводит к проблемам с посещаемостью вашего сайта. Вот как выглядит этот тег:

<meta name=»robots» content=»nofollow».

В большинстве случаев эти ошибки возникают из-за того, что у Google проблемы с Javascript, Flash, редиректами, куками или фреймами. Не стоит беспокоиться об устранении ошибки до тех пор, пока не возникнут проблемы на высокоприоритетных URL-адресах. Если они возникают из-за старых URL, которые не активны, или неиндексируемых параметров, которые служат дополнительной функцией, приоритет будет ниже — но вы все равно должны проанализировать эти ошибки.

Решение

Вот несколько шагов по устранению проблем с несоблюдением:

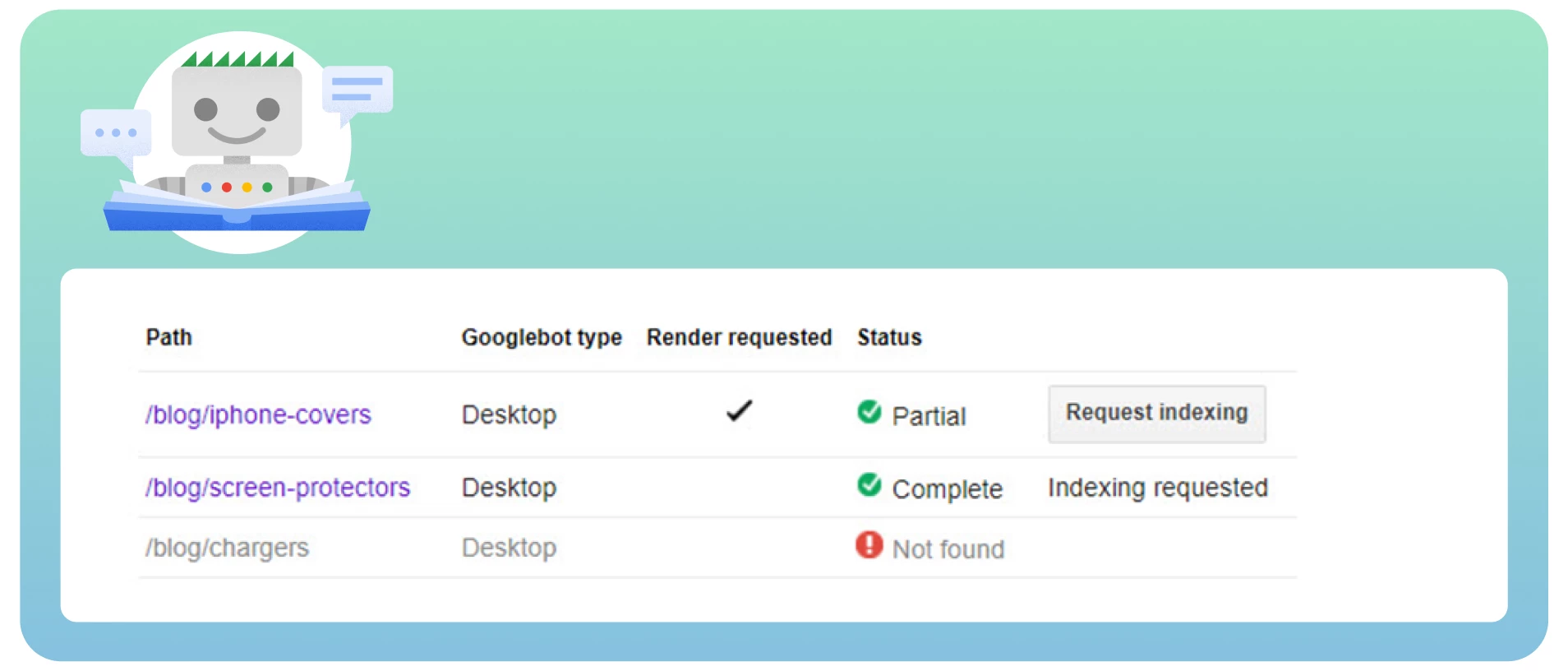

● Просмотрите все страницы с тегами nofollow с помощью инструмента «Fetch as Google», чтобы увидеть сайт так, как это сделал бы Googlebot.

Проверьте наличие цепочек редиректов. Google может перестать следовать за редиректами, если у вас много цепочек.

Включите в карту сайта целевой URL-адрес, а не URL-адреса перенаправления.

Улучшите архитектуру сайта, чтобы на каждую страницу можно было попасть по статическим ссылкам.

Удалите теги nofollow со страниц, где их не должно быть.

3. Заблокированные страницы

Когда боты поисковых систем просматривают ваш сайт, они сначала проверяют ваш файл robots.txt. Потому что он указывает им, какие веб-страницы нужно и не нужно просматривать. Ниже приведен пример файла robots.txt, который показывает, что ваш сайт заблокирован от сканирования:

User-agent: *

Запретить: /

К сожалению, это одна из самых распространенных проблем, которая влияет на наполняемость вашего сайта и блокирует важные веб-страницы. Чтобы решить эту проблему, необходимо изменить директиву в этом файле на «Allow», что позволит ботам поисковых систем просматривать весь сайт.

User-agent: *

Разрешить: /

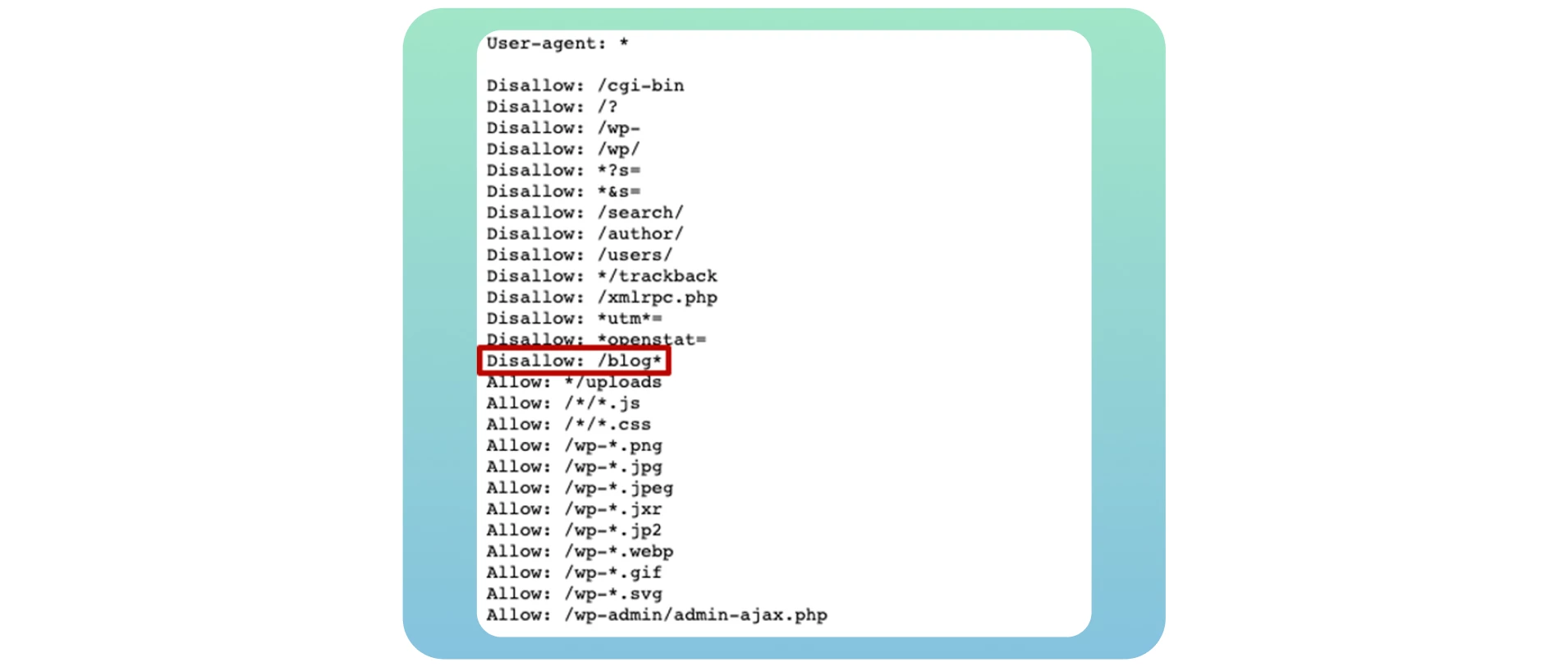

Если вы создаете собственный блог, открыть его для просмотра и индексации необходимо, чтобы получить все потенциальные SEO-преимущества после переноса его на основной сайт. Просто используйте директиву Disallow: /blog*, как показано в примере ниже:

Многие владельцы сайтов заносят в этот файл определенные страницы блога, когда хотят избежать их ранжирования в результатах поиска. В большинстве случаев это относится к страницам входа и благодарности. Но это не является проблемой для краулинга, потому что вы не хотите, чтобы они были видны в результатах поисковых систем. Обнаружение опечатки или ошибки в коде regex приведет к более серьезным проблемам на вашем сайте.

Решение

Если вы хотите, чтобы ваша страница была доступна для просмотра, разрешите это в файле robots.txt. Проверьте свой файл с помощью тестера robots.txt, чтобы найти любые проблемы и предупреждения, а также протестируйте конкретные URL-адреса в вашем файле.

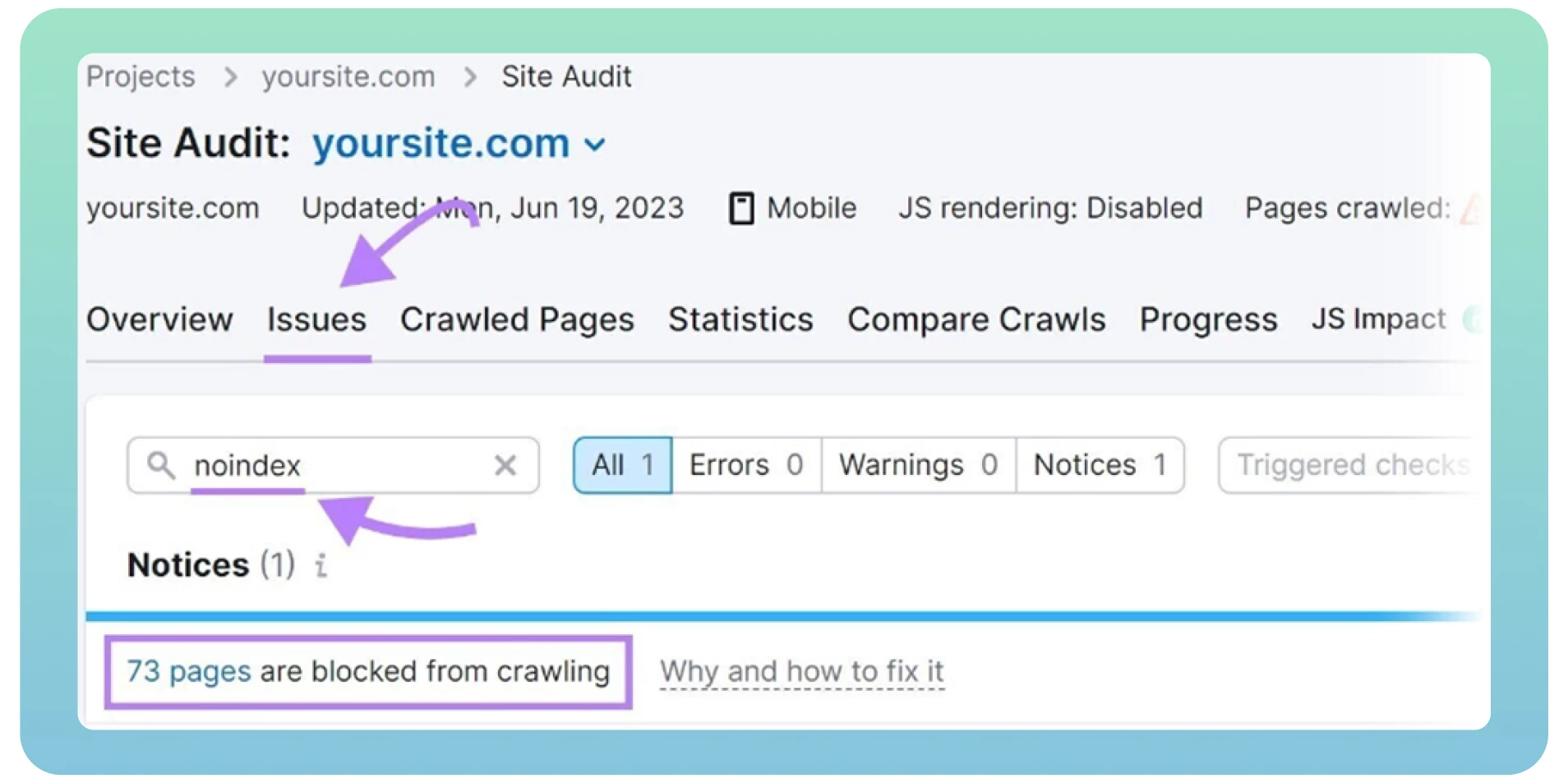

Вы также можете найти любые ошибки robots.txt с помощью аудита сайта. К счастью, существует множество ценных инструментов для проведения технического SEO-аудита, например Screaming Frog или Semrush. Но сначала вам нужно зарегистрироваться и добавить свой сайт, чтобы получить результаты.

4. Теги ‘Noidex’

Теги «Noindex» указывают поисковым системам, какие страницы им не нужно индексировать. Вот как выглядит этот тег ниже:

<meta name=»robots» content=»noindex».

Наличие тегов «noindex» на вашем сайте может повлиять на его наполняемость и индексируемость поисковыми системами, если вы оставите их на своих веб-страницах на длительное время. При запуске сайта в эксплуатацию веб-разработчики часто забывают удалить тег «noindex» с сайта.

Google воспринимает теги «noindex» как «nofollow» и перестает просматривать ссылки на таких страницах. Обычно тег «noindex» ставится на страницах благодарности, входа и администрирования, чтобы предотвратить индексацию Google. В других случаях пора удалить эти теги, если вы хотите, чтобы боты поисковых систем просматривали ваши страницы.

Решение

Вот несколько шагов по устранению проблемы «noindex»:

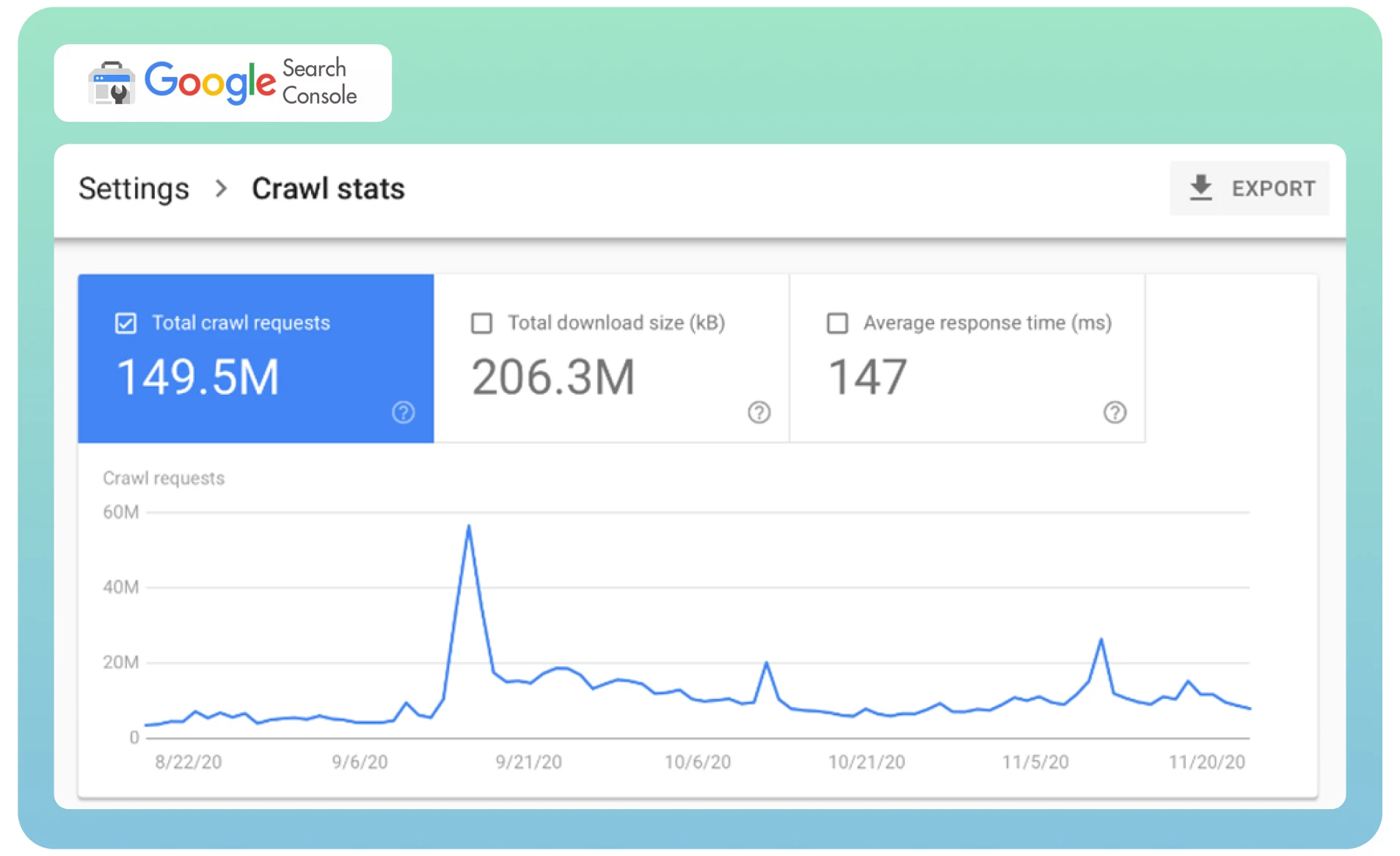

● Проанализируйте статистику посещений в Google Search Console, чтобы определить, как часто бот Google посещает ваш сайт.

Запросите у Google повторное сканирование страницы с помощью инструмента Removals, чтобы немедленно удалить уже проиндексированную страницу из SERP. Это может занять некоторое время.

Используйте инструмент аудита сайта, например Semrush, для обнаружения страниц с тегами «noindex». Он покажет список страниц на вашем сайте, проверит их и удалит, где это необходимо.

5. Дубликаты страниц

Часто разные веб-страницы с одинаковым содержимым могут загружаться с разных URL-адресов, что приводит к дублированию страниц. Например, у вас есть две версии вашего домена (www и не www), ведущие на домашнюю страницу вашего сайта. Эти страницы не влияют на посетителей вашего сайта, но они могут повлиять на восприятие вашего сайта поисковыми системами.

Хуже всего то, что поисковые системы не могут определить, какую страницу считать приоритетной из-за дублирующегося контента. Бот Googlebot быстро просматривает каждую страницу и снова индексирует тот же контент.

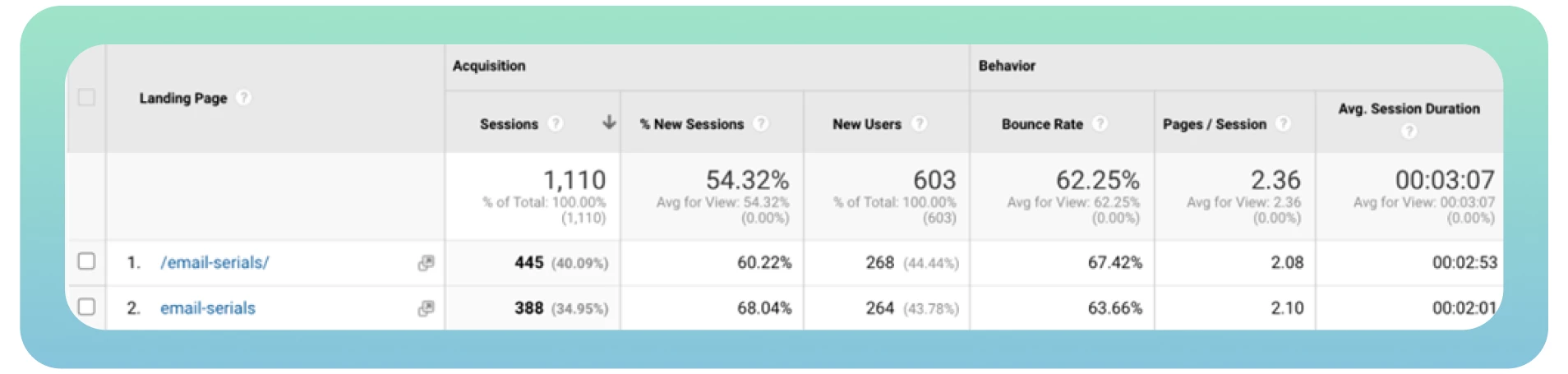

В идеале бот должен просмотреть и проиндексировать каждую страницу только один раз. Кроме того, разные версии одной и той же страницы получают органический трафик и рейтинг страницы, что усложняет анализ показателей трафика в Google Analytics.

Решение

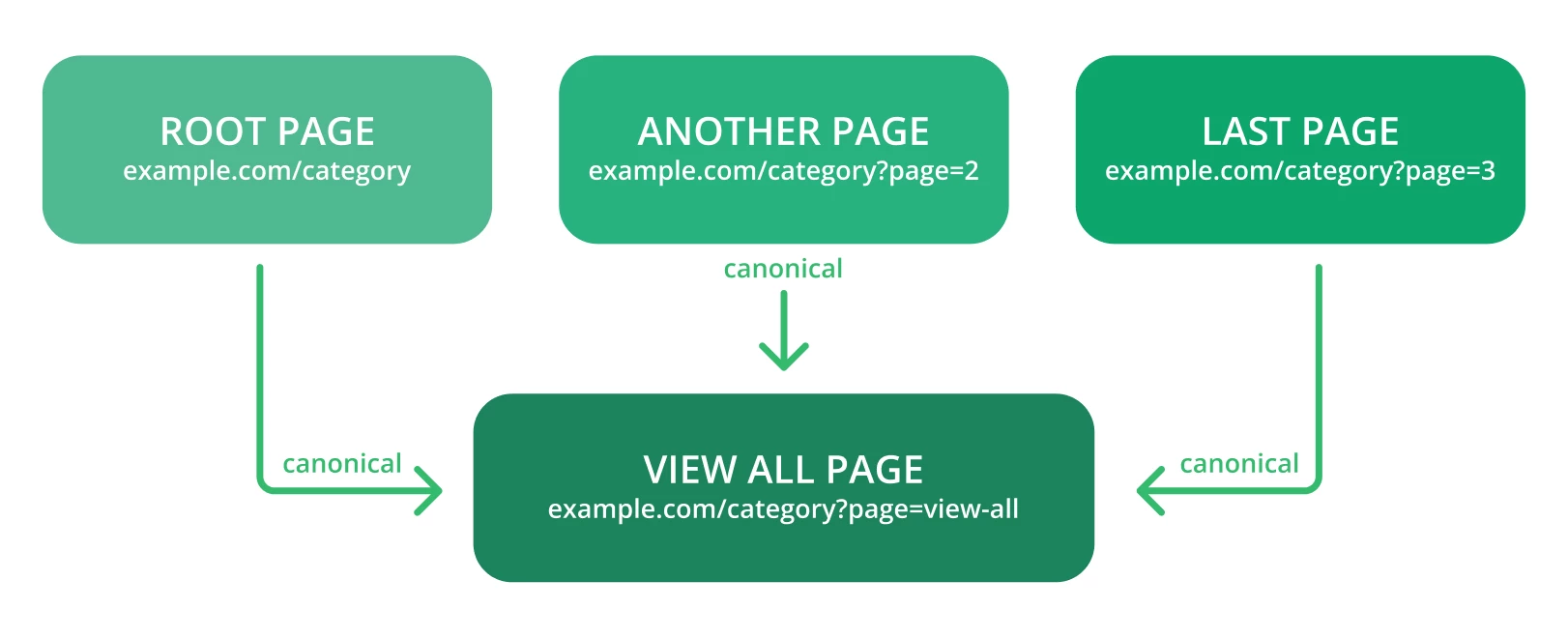

Каноникализация — наиболее предпочтительный способ сохранить SEO-авторитет дубликатов. Вот несколько советов:

● Используйте канонические теги, чтобы Google мог легко определить оригинальный URL страницы. Вот как должна выглядеть ссылка с этим тегом:

<link rel=»canonical» href=»https://example.com/page/» />

● Проверьте предупреждения в Google Search Console — это может быть что-то вроде «Too Many URLs» или аналогичная формулировка, когда Google встречает больше URL и контента, чем должно быть.

● Не используйте одновременно теги canonical и noindex, так как поисковые боты могут расценивать неиндексированные канонические веб-страницы как дубликаты.

● Канонизируйте страницу «Просмотреть все».

● Канонизировать каждый URL-адрес, созданный с помощью фасетной навигации.

6. Низкая скорость загрузки

Скорость загрузки страниц — один из наиболее важных факторов, влияющих на посещаемость вашего сайта. Медленная скорость загрузки может привести к ухудшению качества обслуживания пользователей и сокращению количества страниц, которые поисковые боты могут просмотреть за один сеанс сканирования. Это может привести к тому, что важные веб-страницы будут исключены из просмотра.

Проще говоря, чем быстрее загружаются ваши веб-страницы, тем быстрее бот Google сможет просмотреть содержимое сайта и лучше ранжироваться в результатах поиска. Вот почему повышение общей производительности и скорости сайта имеет огромное значение.

Решение

Вот несколько полезных советов, которые следует учитывать при оптимизации скорости сайта:

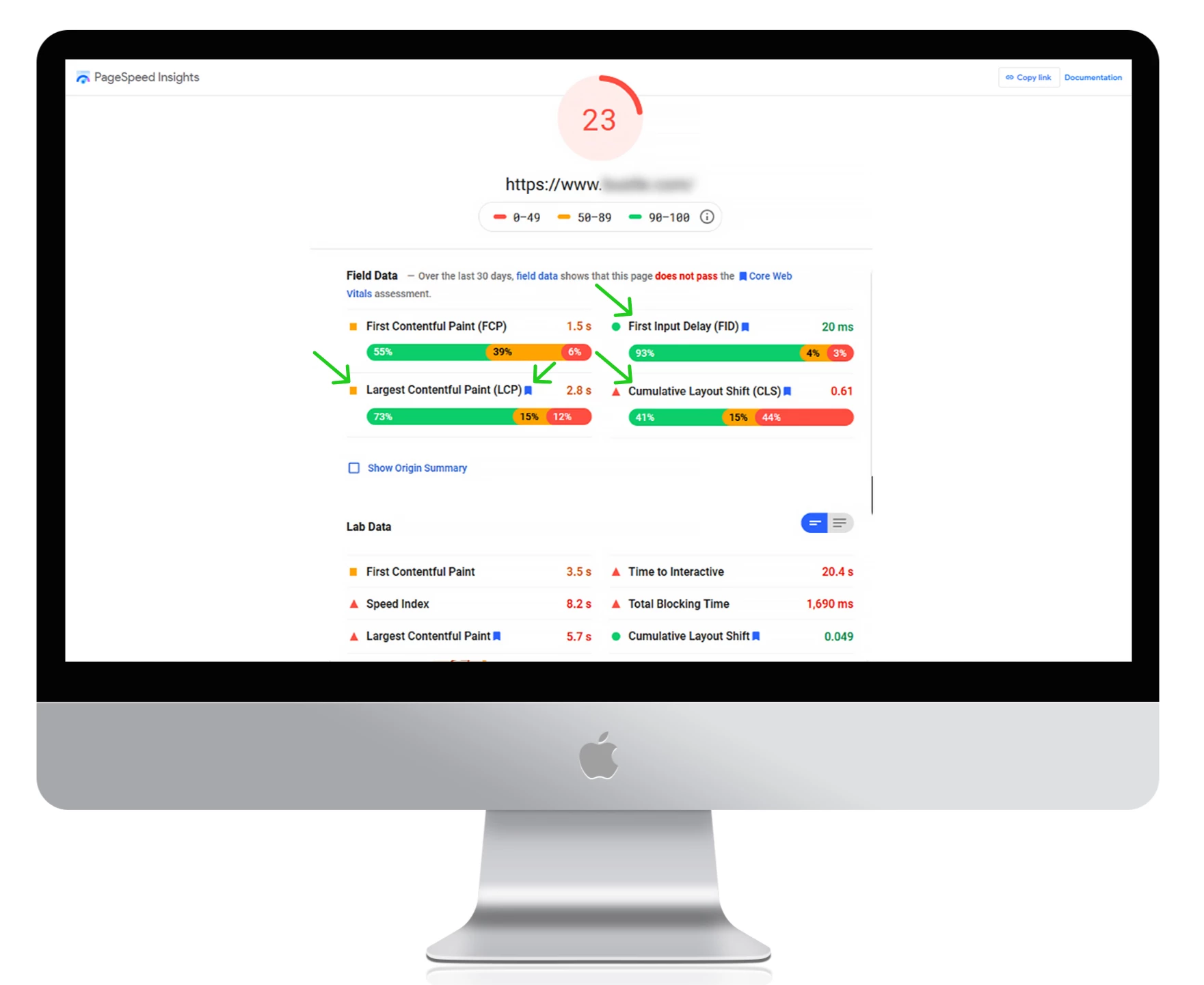

● Используйте Google PageSpeed Insights для измерения текущего времени загрузки, выявления возможных ошибок и получения практических советов по улучшению производительности сайта.

Используйте сеть доставки контента (CDN) для перенаправления контента на различные серверы по всему миру. Это позволит снизить задержки и ускорить работу сайта.

Выберите быстрого хостинг-провайдера.

Сжимайте изображения и видеофайлы, чтобы увеличить скорость загрузки.

Удалите ненужные плагины и уменьшите количество файлов CSS и JacaScript на вашем сайте.

7. Отсутствие внутренних ссылок

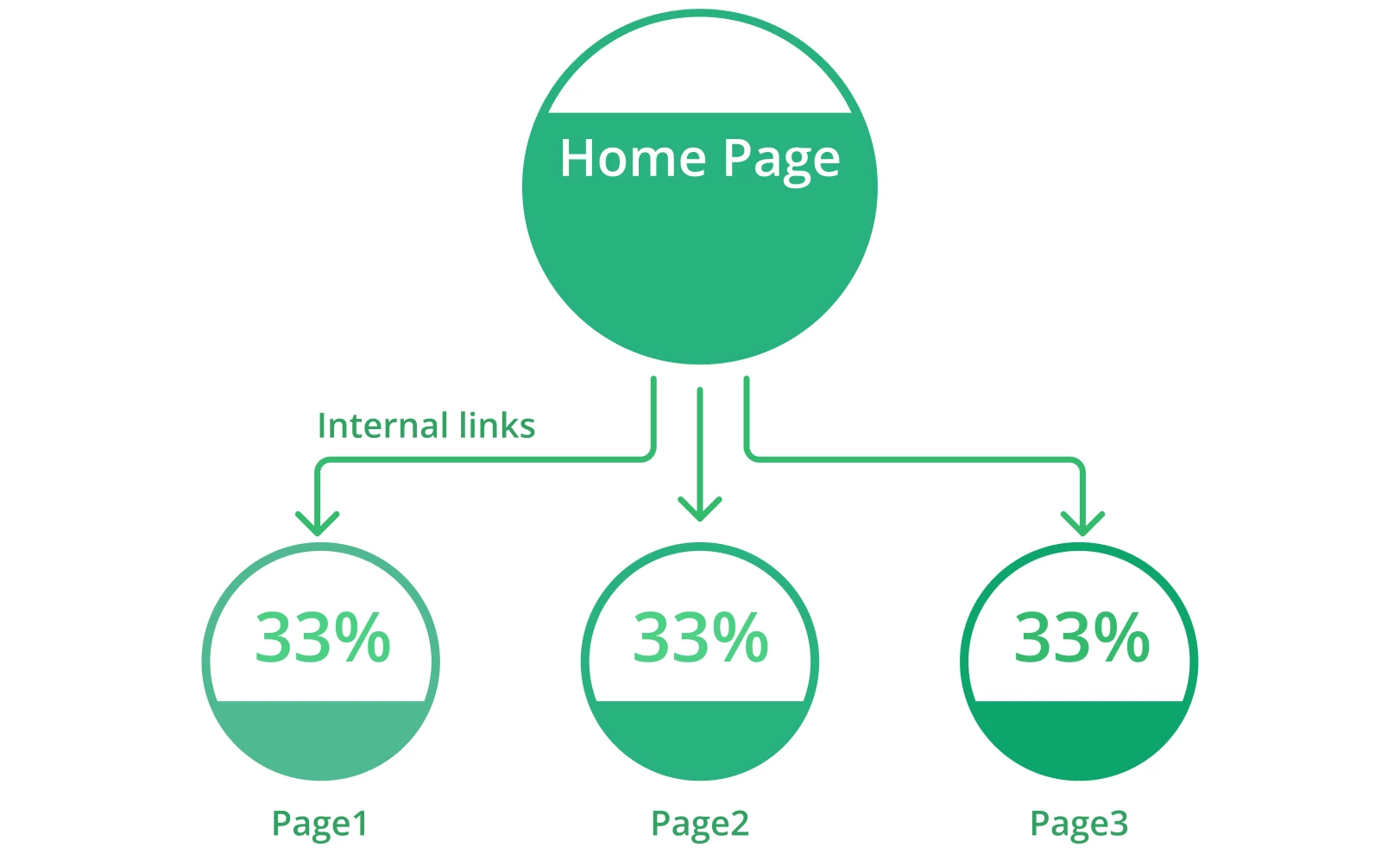

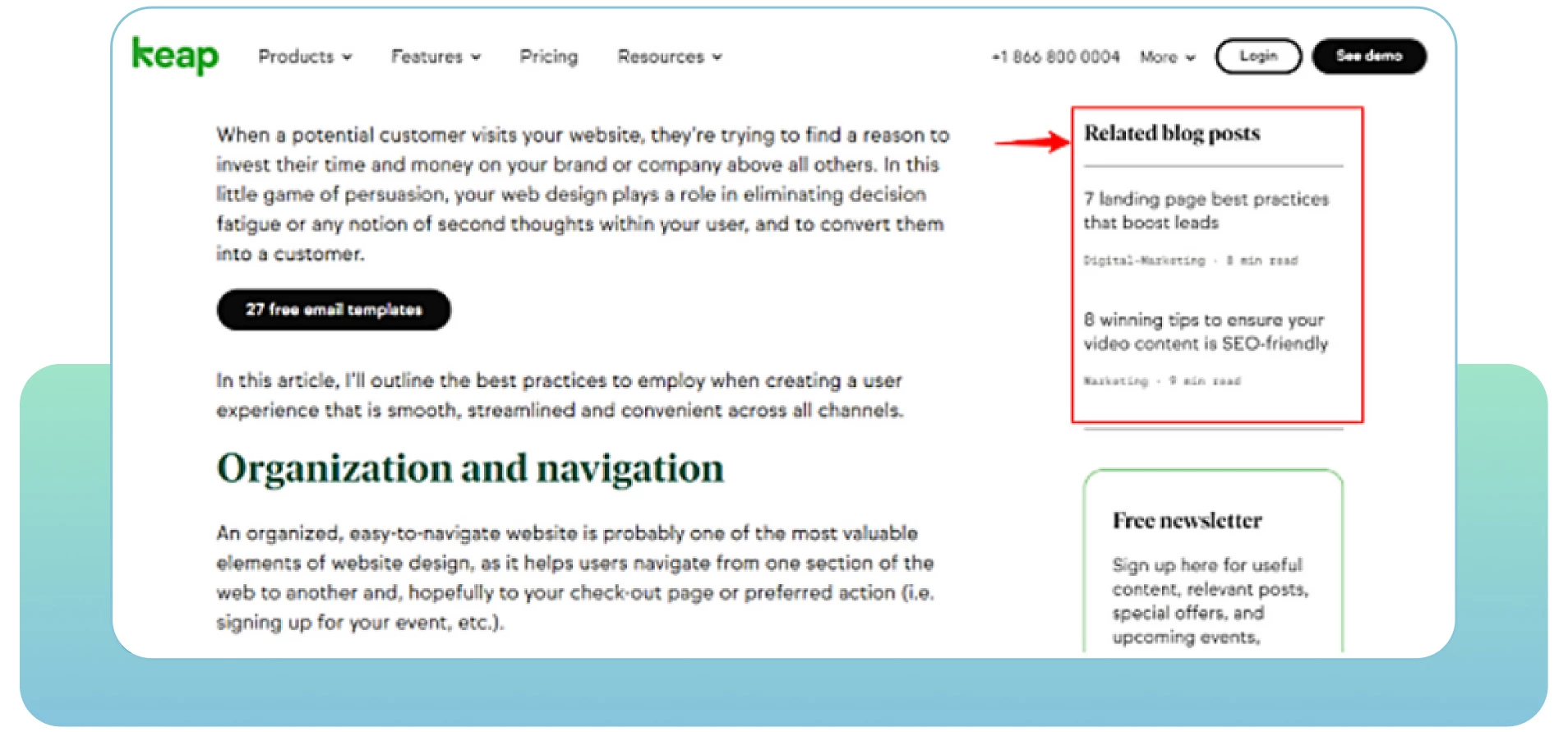

Веб-страницы с недостатком внутренних ссылок могут столкнуться с проблемами сползаемости. Внутренние ссылки — это ссылки, связывающие одну страницу с другой соответствующей страницей в пределах одного домена. Они помогают пользователям легко ориентироваться на вашем сайте и предоставляют поисковым системам полезную информацию о его структуре и иерархии.

На каждой странице вашего сайта должна быть хотя бы одна внутренняя ссылка. Это покажет поисковым системам, что ваши страницы взаимосвязаны и взаимодействуют между собой. Изолированные страницы не позволяют ботам считать их частью вашего сайта. Чем больше у вас релевантных внутренних ссылок, тем легче и быстрее боты просмотрят весь сайт.

Решение

Вот несколько полезных советов:

● Проведите SEO-аудит, чтобы определить, где нужно добавить больше внутренних ссылок с релевантных страниц вашего сайта.

● Просмотрите аналитику сайта, чтобы увидеть, как пользователи перемещаются по сайту, и найти способы привлечь их с помощью вашего релевантного контента. Обратите внимание на страницы с высоким показателем отказов, чтобы улучшить их и добавить больше качественного контента.

Определите приоритет важных страниц, поместив их выше в иерархии сайта и добавив на них больше внутренних ссылок.

Включите описательные тексты анкоров, чтобы показать содержание страниц, на которые ведут ссылки.

Обновите старые URL-адреса или удалите неработающие ссылки. Убедитесь, что все ссылки на вашем сайте актуальны и активны.

Перепроверьте и удалите все опечатки в URL, которые вы указываете на своих веб-страницах.

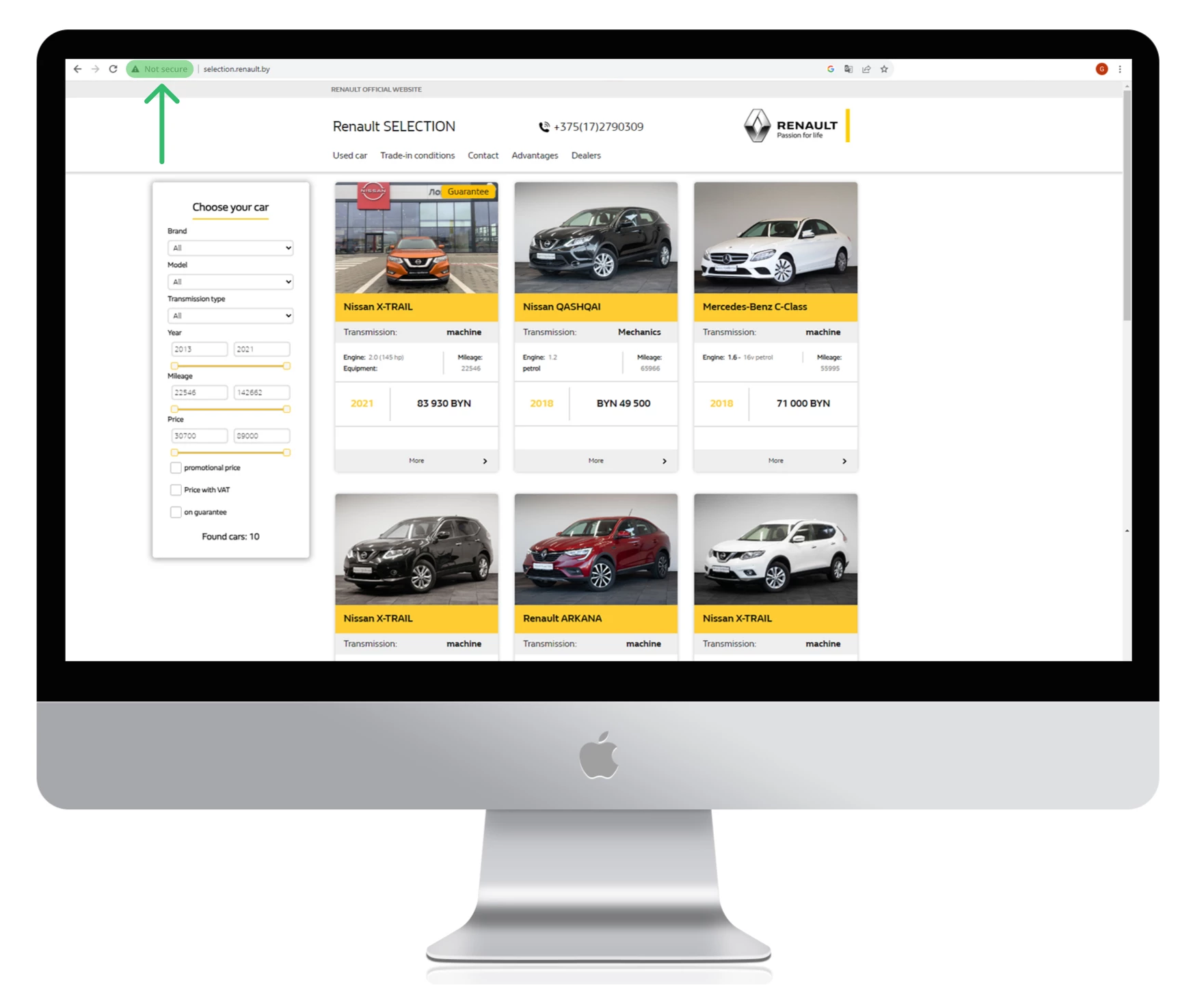

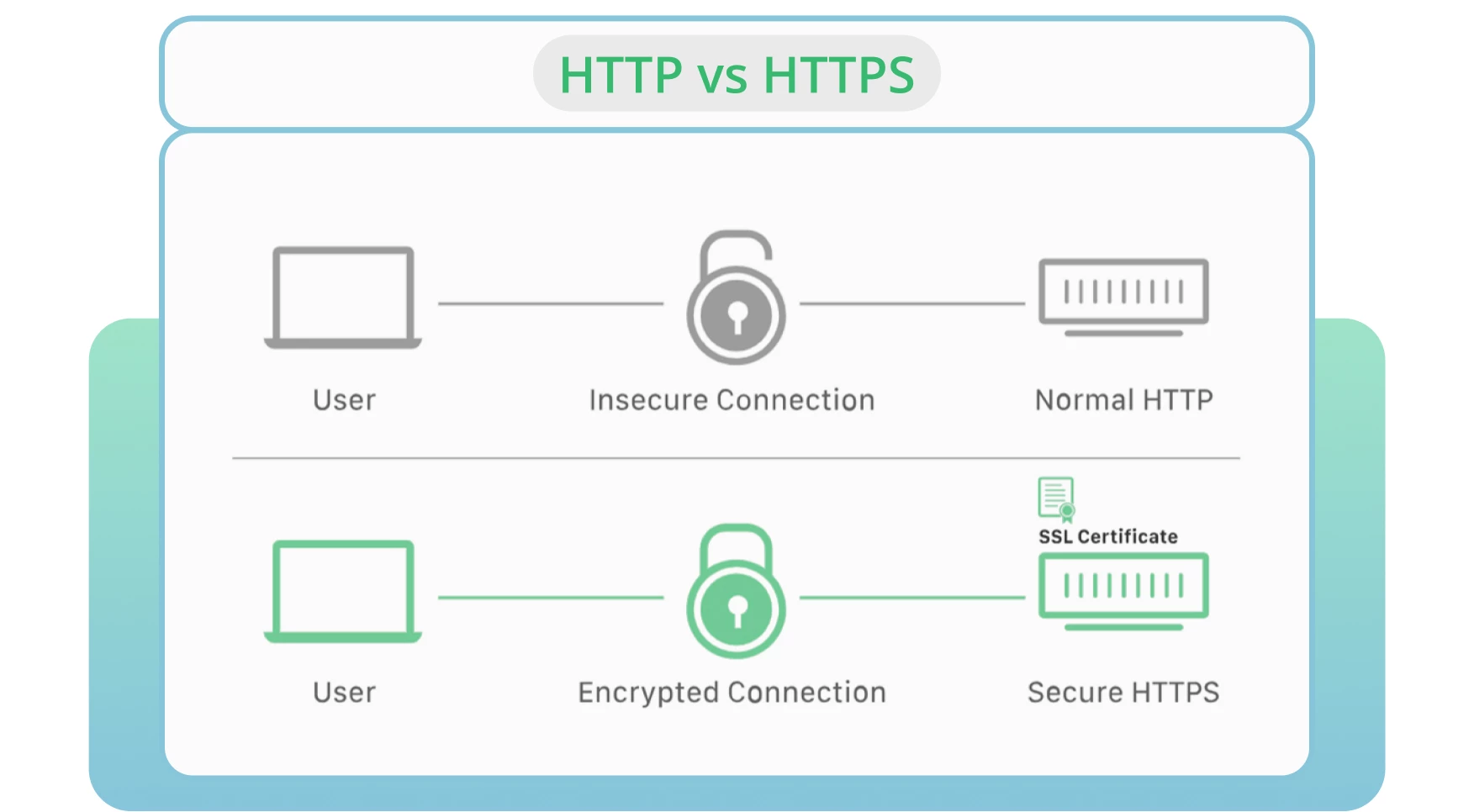

8. Использование HTTP вместо HTTPS

Безопасность серверов остается одним из основных факторов при поиске и индексации. HTTP — это стандартный протокол, по которому данные передаются от веб-сервера к браузеру. HTTPS считается наиболее безопасной альтернативой версии HTTP.

В большинстве случаев браузеры предпочитают HTTPS-страницы вместо HTTP-страниц. Последнее негативно сказывается на рейтинге сайта и его посещаемости.

Решение

Получите SSL-сертификат, чтобы помочь Google быстро просмотреть ваш сайт и поддерживать безопасное и зашифрованное соединение между вашим сайтом и пользователями.

Переведите свой сайт на версию HTTPS.

Следите за протоколами безопасности и обновляйте их. Избегайте просроченных SSL-сертификатов, старых версий протоколов или неправильной регистрации информации о вашем сайте.

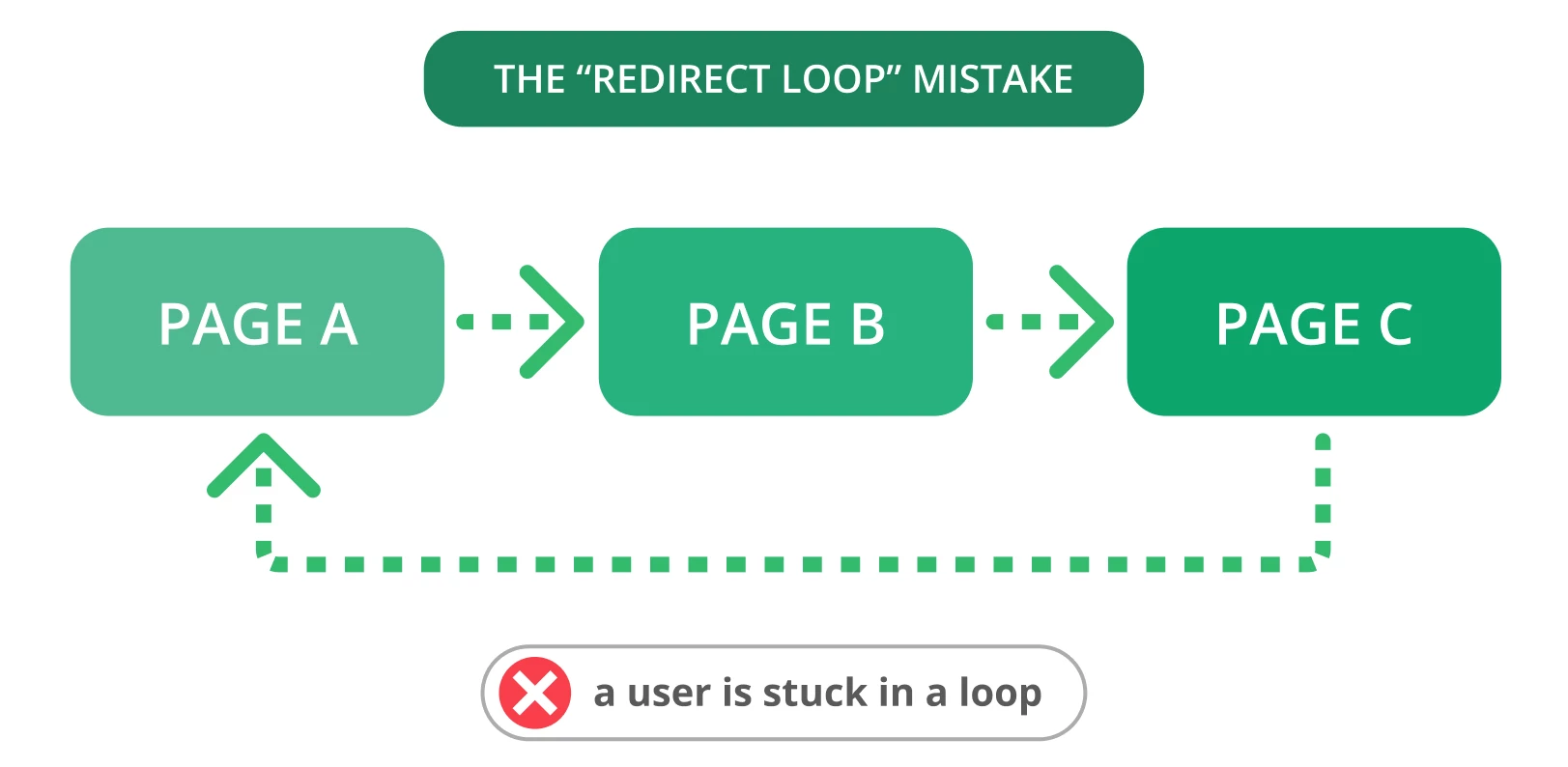

9. Петли перенаправления

Перенаправления необходимы, когда вам нужно направить старый URL на новую, релевантную страницу. К сожалению, часто возникают проблемы с перенаправлением, например, петли перенаправления. Это может расстроить пользователей и помешать поисковым системам просматривать ваши страницы.

Петля редиректа — это когда один URL перенаправляет на другой, возвращаясь к исходному URL. Эта проблема создает для поисковых систем бесконечный цикл перенаправлений между двумя или более страницами. Это может негативно сказаться на бюджете поисковой выдачи и на посещаемости важных страниц.

Решение

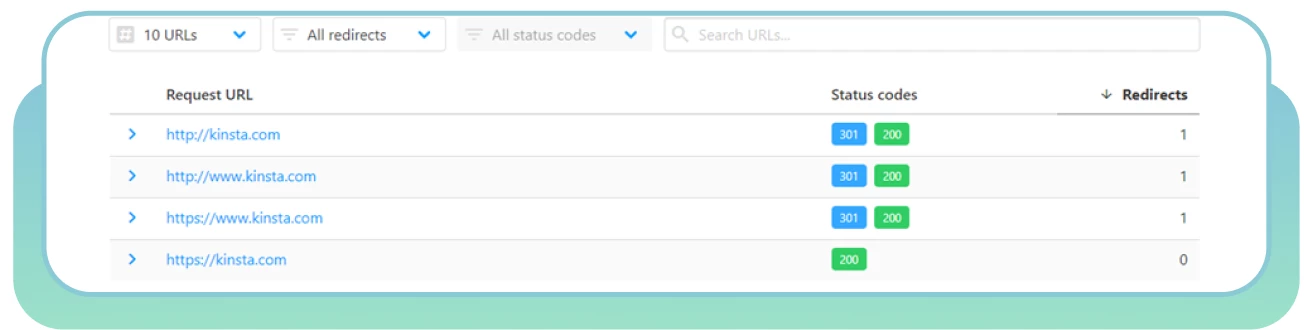

Вот несколько шагов по устранению петель перенаправления:

● Используйте HTTP Status Checker, чтобы быстро найти цепочки перенаправлений и коды состояния HTTP.

Выберите «правильную» страницу и перенаправьте на нее другие страницы.

Удалите перенаправление, вызвавшее зацикливание.

Пометьте страницы с кодом состояния 403 как nofollow, чтобы оптимизировать бюджет на переползание. Эти страницы могут быть использованы только для зарегистрированных пользователей.

Включите временные редиректы, чтобы сообщить поисковым ботам о необходимости вернуться на вашу страницу. Используйте постоянное перенаправление, если вы больше не хотите индексировать исходную страницу.

10. Плохая архитектура сайта

Организация страниц и контента вашего сайта является одним из наиболее важных факторов при оптимизации его посещаемости. Плохая архитектура сайта приводит к ошибкам при обнаружении гусеницами веб-страниц, которые находятся низко в иерархии или не связаны между собой (так называемые «сиротские страницы»).

Хорошо структурированный сайт поможет поисковым системам легко находить и получать доступ ко всем страницам, что может положительно сказаться на производительности и SEO. Идеальная структура сайта означает, что каждая страница находится на расстоянии нескольких кликов от главной страницы и не содержит бесхозных страниц.

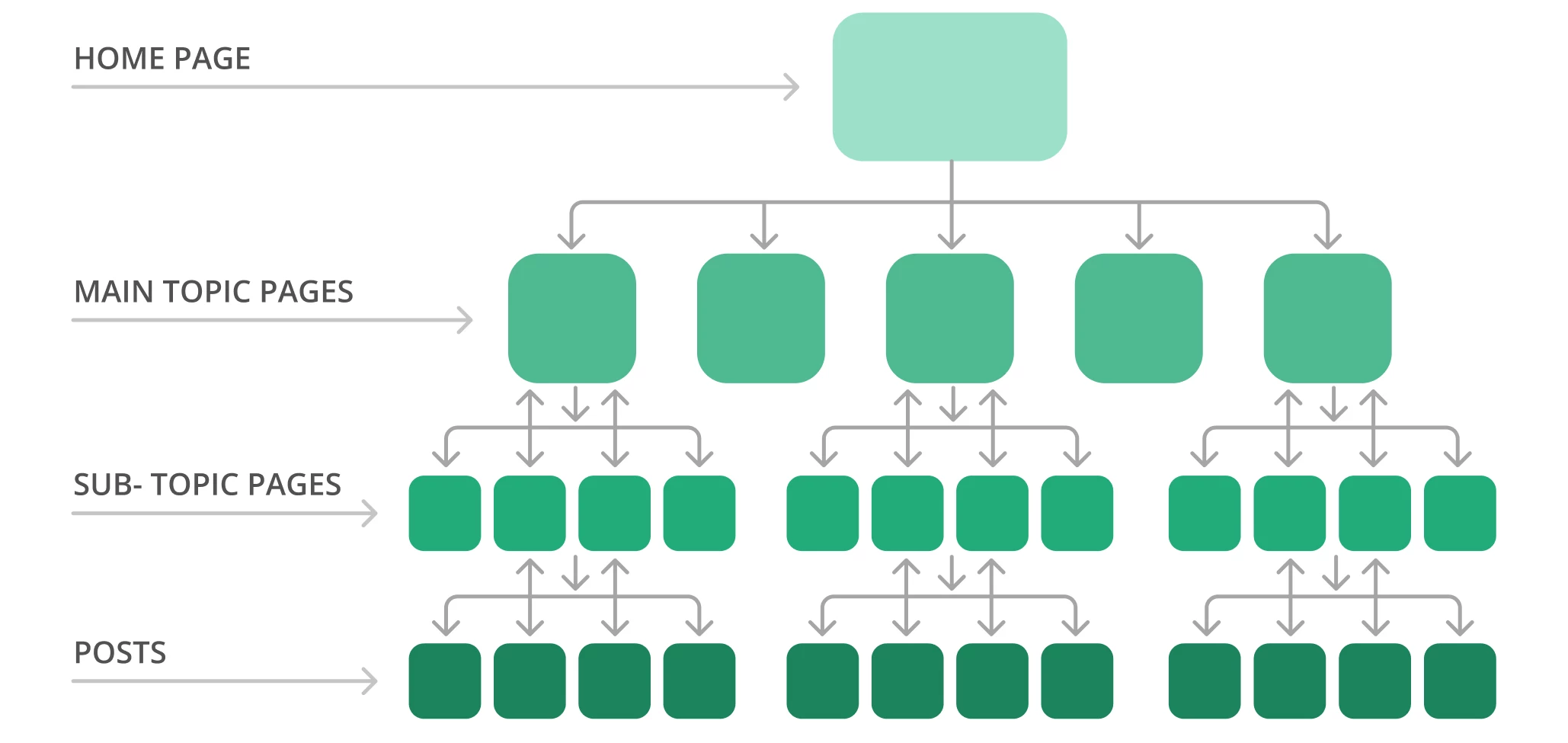

Например, типичная структура сайта может выглядеть как пирамида. На вершине находится главная страница, а на ней несколько слоев, ссылающихся на страницы основной темы и ведущих к страницам подтем. Обратите внимание на пример структуры сайта ниже.

Google обычно просматривает сайт от верхней части главной страницы до нижней. Другими словами, чем дальше ваши страницы находятся от вершины, тем сложнее поисковым ботам их найти, особенно если у вас много страниц-«сирот».

Решение

Вот несколько шагов по оптимизации архитектуры вашего сайта:

Используйте Screaming Frog, чтобы проверить текущую структуру сайта и глубину сканирования.

Организуйте страницы логически в виде иерархии с внутренними ссылками. Делайте важнейшие страницы в два-три клика от главной страницы.

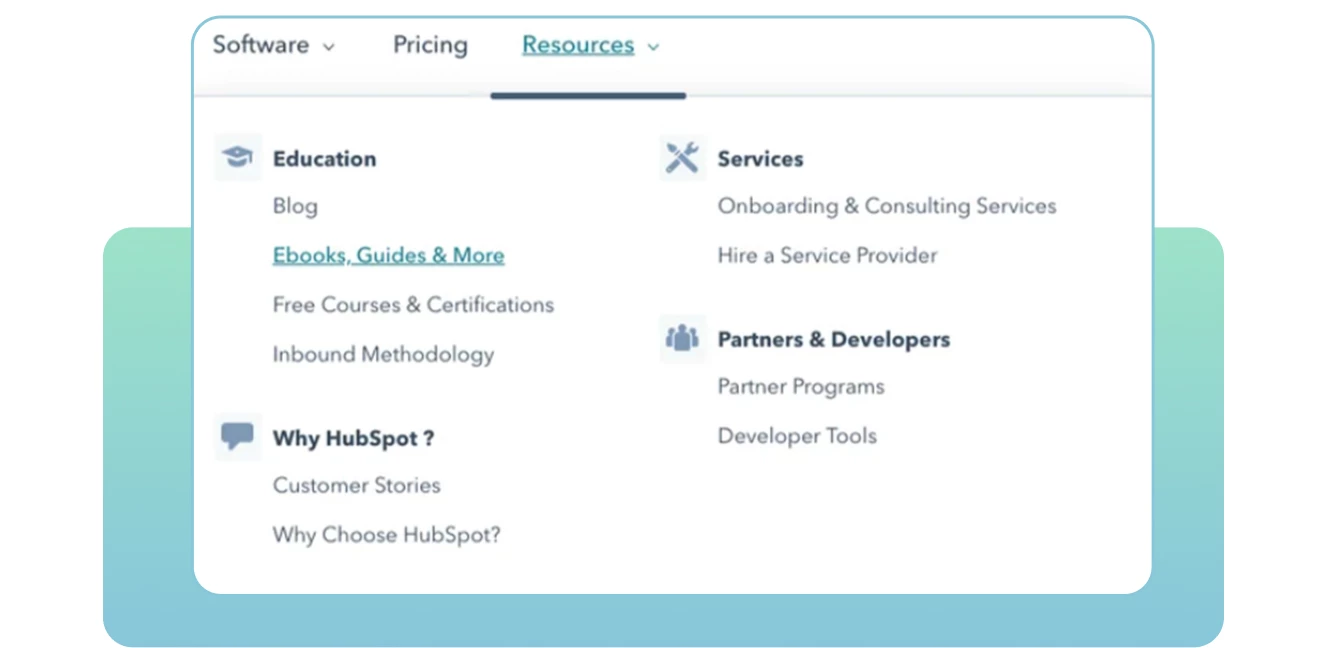

● Создайте четкую структуру URL. Сделайте ее легко читаемой, чтобы поисковые системы и пользователи понимали контекст и релевантность каждой страницы на вашем сайте. По возможности включайте целевые ключевые слова в каждый URL.

● Используйте статические URL-адреса и избегайте использования динамических, включая идентификаторы сессий или другие параметры URL-адресов, которые затрудняют сканирование и индексацию ботами.

● Создавайте хлебные крошки, чтобы помочь Google понять ваш сайт, а людям — быстро перемещаться вперед и назад.

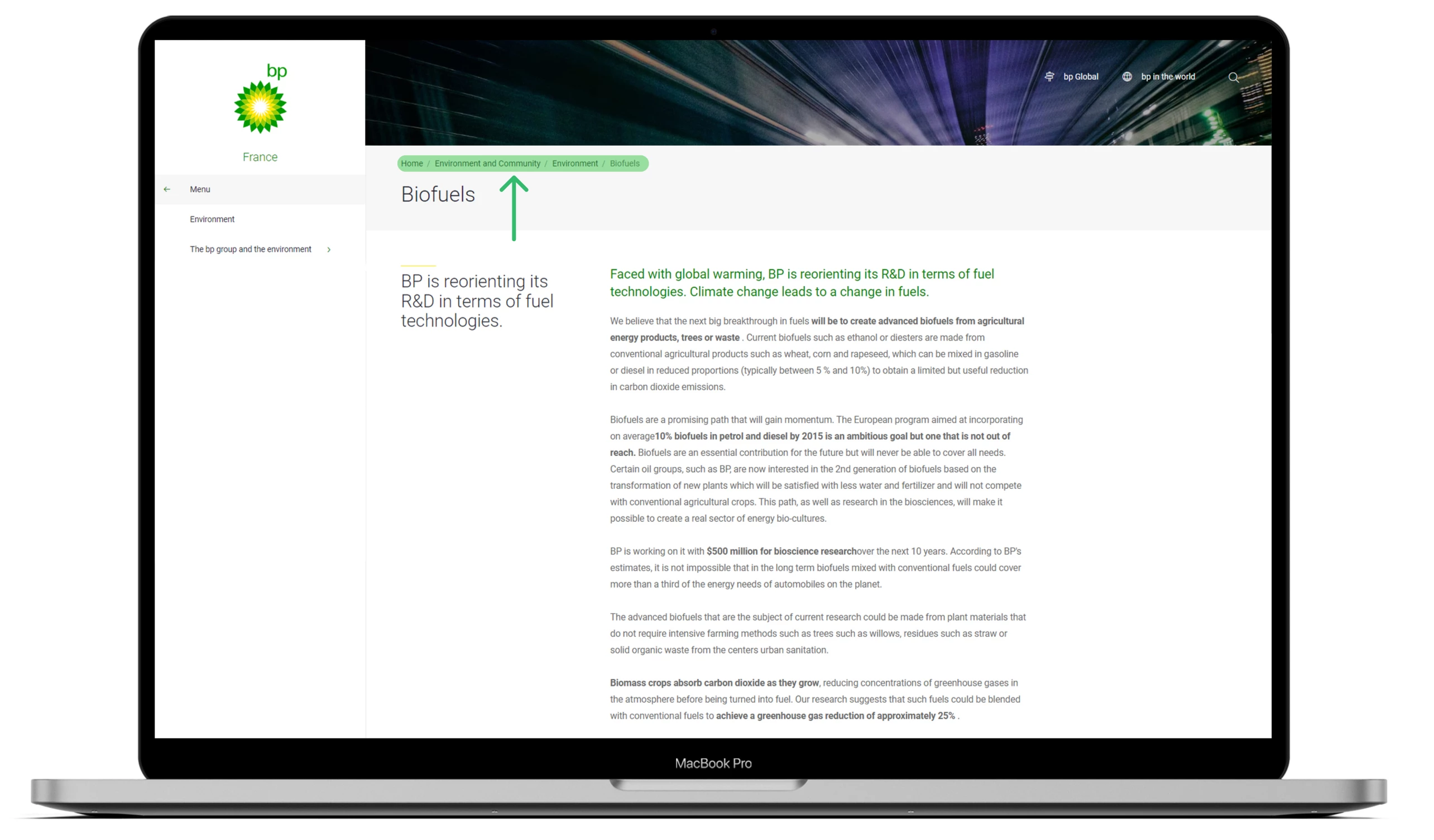

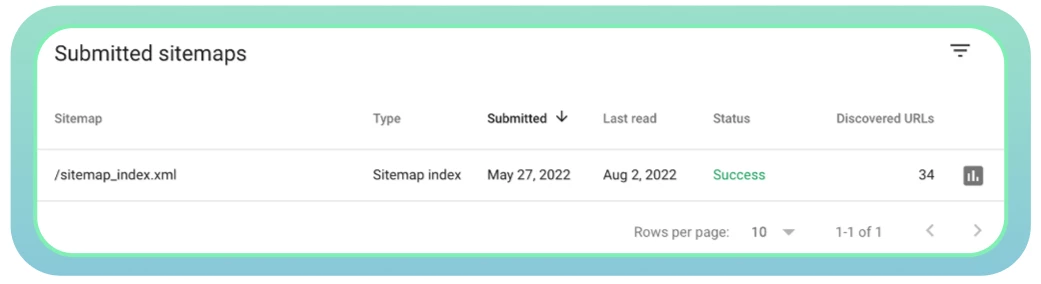

11. Плохое управление файлами Sitemap

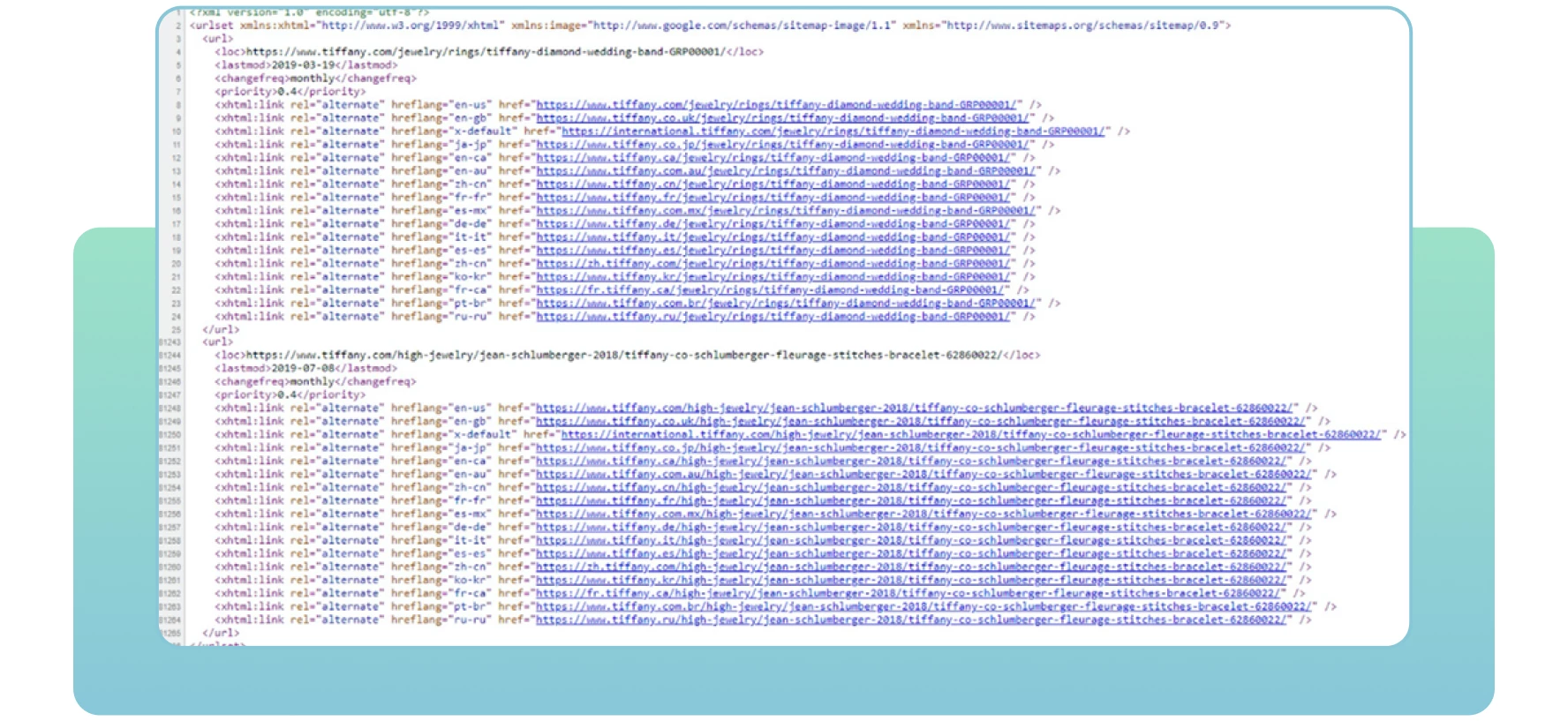

Sitemap — это XML-файлы, содержащие важную информацию о страницах вашего сайта. Они указывают поисковым системам, какие страницы являются важными на сайте, который вы хотите просмотреть и проиндексировать. Карта сайта также содержит информацию об изображениях, видео и других медиафайлах вашего сайта. Ниже приведен пример карты сайта:

С помощью карты сайта поисковые системы смогут эффективно находить и просматривать ваши важные веб-страницы. Если вы не включите некоторые страницы, которые необходимо проиндексировать и ранжировать, поисковые системы могут их не заметить, что приведет к проблемам с проходимостью и снижению посещаемости сайта.

Решение

Вот несколько шагов, которые следует предпринять в отношении карт сайта:

Используйте инструмент XML Sitemaps для создания или обновления карты сайта.

Убедитесь, что в нее включены все необходимые страницы и что в ней нет ошибок сервера, которые могут затруднить доступ веб-гусениц.

Отправьте карту сайта в Google. Обычно ее можно найти по URL-адресу вашего сайта, как показано ниже: domain.com/sitemap.xml

Используйте Google Search Console, чтобы отслеживать состояние карты сайта и проверять любые проблемы, связанные с ней.

● Обязательно обновляйте карту сайта после добавления или удаления новых страниц на вашем сайте. Это поможет поисковым системам получать точную информацию обо всех ваших веб-страницах.

Заключение

Существует множество причин, по которым некоторые страницы вашего сайта скрыты от Google и вообще не ранжируются. Во-первых, проверьте, нет ли на вашем сайте проблем с проходимостью.

Множество ошибок при переползании могут повлиять на производительность вашего сайта и сообщить поисковым ботам, что определенные веб-страницы не стоит переползать. В результате Google не будет индексировать и ранжировать ваши важные страницы, к которым они не могут получить доступ.

Поэтому очень важно найти все проблемы с проходимостью и сделать все возможное для их устранения. Применяя упомянутые ранее решения, вы сможете оптимизировать свой сайт для лучшей работы и помочь поисковым системам и пользователям легко находить его.

Дорогие друзья! Надеюсь, статья оказалась интересной, и я буду очень рад, если она принесет вам пользу. До скорой встречи!